ARTICLE AD BOX

robots.txt記錄比我們今天使用的狩獵引擎更古老,它只是網絡上的一隻恐龍。儘管有大量討論協定的文章,但對於檔案的使用,本站將自動篩選過度的歧義、國家案例和不同的未記錄場景

你為什麼要在乎

robots.txt只是一個方便的、可分析的搜尋引擎優化工具,如果不小心處理,很容易產生意想不到的結果。雖然在使用“允許”和“不允許”指令時,我們有意識地排除過度的拼寫錯誤和模糊的俄勒岡州衝突規則,但我們還應該認識到,在這些情况下,狩獵引擎的行為是多麼成功

robots.txt:網絡上的泡芙食品

robots.txt類似於河豚魚:美味但有毒。長期食用砷是無害的,但SEO廚師知道如何使用它。他們認識記錄格式、語法和分組規則。它們承認用戶代理的優先權,但基於URL匹配的連接管道值起作用

機器人排除協定(REP)已經慶祝了25年,其規範還沒有通過不適當的呼叫規則正式化。然而,我們無法觀察到SEO和網站管理員社區的誤用和混亂,不幸的是,這會影響成功的次優展示和對過度網站的成功蒐索

囙此,讓我們;讓我們澄清和發展過度的環境困惑規則

快速實施我們開始得更早:過度的螢幕截圖成功本站娛樂我們的robots.txt驗證和調查工具,該工具基於physique連接了原型robots.txt檔案,其行為類似於追跡工具和庫(也利用了我們的成功研究):

穀歌蒐索控制台;s robots.txt測試儀總結這些工具,我們;ve除了利用百度;s robots.txt Tester,並確認我們的測試結果將未記錄的URL(未爬網的俄勒岡州)與服務器日誌檔連接起來

1)將忽略尾隨萬用字元

據穀歌稱;s robots.txt規範中,將忽略尾隨萬用字元

但這是真的嗎?好吧,是和否。它是“忽略”成功就是意識到决心是一種“成功”;隱式”*萬用字元astate不以$結尾的每條路徑的端點(這是明確指定URL端點的不同萬用字元)

囙此,/fish=/fish*以前只是簡單地將URL與路徑匹配

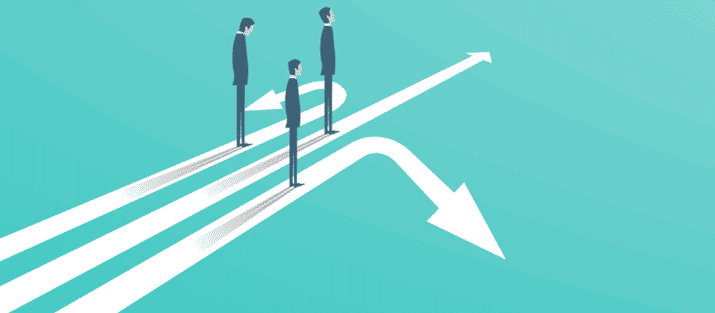

但是,在合計路徑長度時,不會忽略尾隨萬用字元。這在過去變得很重要,儘管同時使用了禁止和允許規則,但部分不同的是,它們提供了一個特殊的URL(或可接受的URL)

這條路的規模是非常重要的 在URL中確定以前聚合行(規則)的優先順序出價

在上圖中,URL將被封锁爬行 因為Disallow連接比(也匹配)Allow指令長

在規範中,穀歌表示“穀歌:;在衝突規則的訴訟中[…]使用了最輕微的限制性規範。”;換言之,如果某些匹配路徑的長度超過上述長度,則使用允許正則化意志鈹

正如成功的例子所示,穀歌的成功;s檔案&hellip

…並清楚地說明了代表草案的成功之處

現在,回到我們的尾隨萬用字元。如果將1添加到“鈹”中;失去”在我們以前的例子中,判决將與鈹不同

使用尾隨萬用字元時,只要不允許規則的管道存在,Allow指令的管道就存在,並且TROUTH優先

使用尾隨萬用字元時,Disallow指令的管道將出現更長的時間,並且正在使用TRUSTER,因為尾隨萬用字元不是“忽略”以前在確定像散時“具體的”基於lucifer的連接長度。

2)政府;未定義帶有萬用字元的規則的優先順序

穀歌;向首長部門提供的檔案;帶有萬用字元的規則的優先順序未定義&rdquo

English (US)

English (US)